英伟达杀疯了!Blackwell横扫市场,AMD、英特尔加入降本浪潮

电子发烧友网报道(文/莫婷婷)2月27日凌晨, 英伟达公布了2025财年第四财季的财务数据,这是DeepSeek面世后的第一份财报,业内人士尤为关注DeepSeek给英伟达或者是 GPU市场带来的驱动力。与此同时,随着 AI大模型的普及,高计算量需求和成本压力也成为行业关注的焦点。如何在性能与成本之间找到平衡,成为整个AI 芯片行业共同面临的挑战。AI大模型的出现对芯片市场产生了哪些影响,DeepSeek带来的“AI降本浪潮”又会给 AMD和 英特尔带来哪些机会?

英伟达2025财年营收暴涨114%,Blackwell单季营收百亿美元

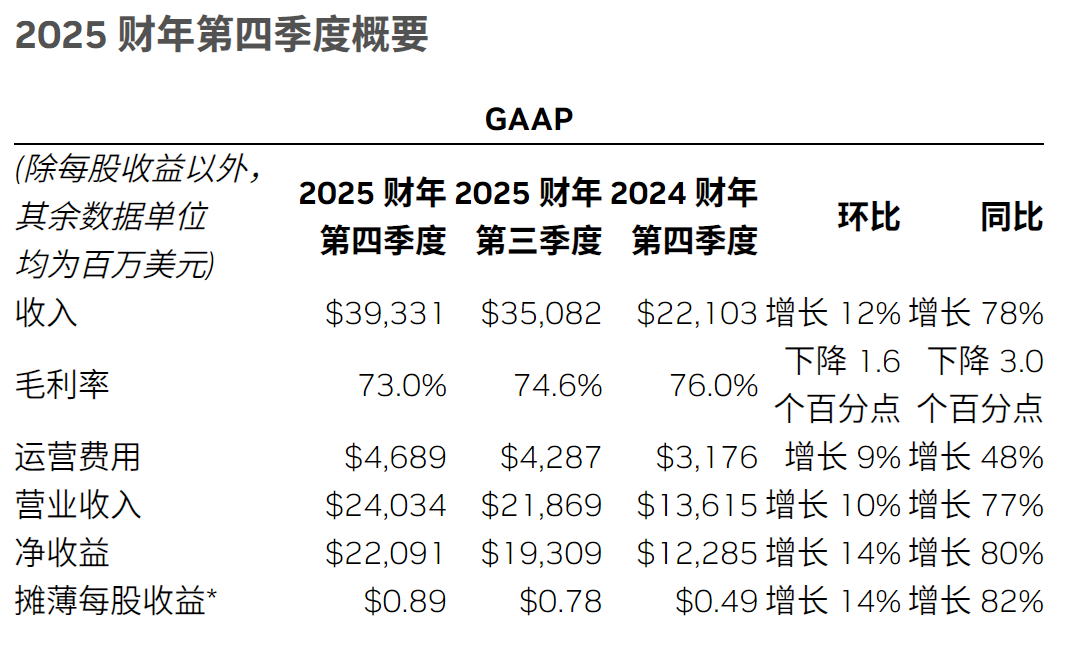

先来看备受瞩目的英伟达的业绩情况。在2025年第四财季,英伟达的营收达393亿美元,环比增长12%,同比增长78%,高于预期,净利润221亿美元,同比大幅增长80%。

全年来看,英伟达2025财年共实现营收1304.97亿美元,同比增长114%;全年净利润达到728.80亿美元,同比增长145%。Blackwell芯片实现首季度销售额突破110亿美元。2025财年数据 中心业务营收达到1152亿美元,同比上一年实现翻倍增长。

英伟达表示受测试时的规模扩展以及OpenAI的o3、DeepSeek - R1和Grok - 3等新推理模型的驱动, 公司的推理业务需求呈现加速增长。长思考推理 人工智能比单次思考推理人工智能的计算力需求高出100倍。第四季度财报电话会议上, 黄仁勋表示,“例如Grok-3、DeepSeek-R1的大模型应用了推理时间扩展的推理模型。推理模型的计算量可能是早期大语言模型的100倍。”

这也带动了英伟达Blackwell的销量。第四季度数据中心业务营收356亿美元,同比增长93%,创下历史新高。仅仅是Blackwell的营收就达到了110亿美元。

黄仁勋提到,“训练后优化阶段,强化学习、微调、模型压缩等所需的计算量比单独的预训练高出几个数量级。推理时间的扩展和推理过程中,单个查询所需的计算量增加了100倍。”这意味着未来AI大模型的升级将对AI芯片的需求将呈现增长态势。

英伟达 产品的性能提升速度非常快速,更明显的改进还有成本,这也是当下AI大模型产业最为关注的。与Hopper 100相比,Blackwell的吞吐量提高25倍,成本降低20倍。Transf ormer引擎专为大语言模型(LLM)和混合专家模型设计,其NVLink域的吞吐量是PCIe Gen5的14倍,确保了在大规模处理推理任务时所需的响应时间、吞吐量和成本效益。

“AI降本浪潮”中,AMD、英特尔追赶英伟达

DeepSeek带来的不仅仅高计算量需求。我们看到,DeepSeek为英伟达带来超预期的业绩表现,同样也为AMD带来未来乐观的展望,这主要得益于“低成本风暴”。

DeepSeek通过其高效的 算法和技术,降低了AI训练和推理的成本。DeepSeek V3 模型的训练时长约为280万 GPU 小时,总成本仅为557.6万美元左右。作为对比Llama 3 405B的训练时长约为3080万GPU小时。DeepSeek的成本极致表现曾让业内人士纷纷研究如何用“白菜价”造出最强的AI大模型,也由此掀起了一股“降本浪潮”“低成本风暴”,如何用更低的成本开发、部署大模型并实现正向商业化成为一个新的目标,而这给了AMD、英特尔机会。

据了解, 厂商在基于DeepSeek R1模型提供服务时,尽管该模型旨在通过更高效的算法减少对高端硬件的依赖从而降低总体成本,但算力成本依然很高,并且MaaS(模型即服务)的价格并未如预期那样下降。导致这种问题的原因包括初始硬件投资、持续的运营成本等。在初始硬件投资方面,即使DeepSeek R1降低了某些任务的计算需求,但为了支持其运行以及处理更大规模的数据集或更高要求的应用场景,厂商仍需投资GPU或TPU等高性能的硬件设备,这些硬件的成本本身并不低。潞晨 科技创始人尤洋在微博表示,“用户越多,亏损越多”。